Datenqualitätsanalyse für Produktdaten

299,00 €

exkl. 19 % MwSt.

Unsere vollautomatische Produktdatenqualitätsanalyse auf mehr als 35 Metriken erlaubt nachhaltige Identifikation und Verbesserung der Datenqualität.

Beschreibung

Diese Daten brauchen wir

- Inhalt: Ein Produktdatensatz

- Quellen: Beliebiges System, z.B. PIM, MDM, PLM, PDM oder Excel-Listen

- Format: Eine Reihe ein Produkt, beliebige Anzahl an Spalten

Analyse der Produktdatenqualität: Ein Muss, um konsistent zu sein

Produktdaten sind in der Regel eine der wichtigsten Datenquellen innerhalb eines Unternehmens. In den letzten Jahren ist die Zahl der digitalen Kanäle explodiert, was dazu führt, dass hochwertige Produktdaten für die Bereitstellung von Produkten an potenzielle Kunden immer wichtiger geworden sind.

Die Analyse der Datenqualität von Produktdaten ist jedoch oft ein langwieriger Prozess. Die Kapazitäten der Produktinformationsmanagement-Teams sind gering, die Daten sind oft sehr umfangreich und es fehlt ein etabliertes Data Governance Konzept.

Unsere Analyse der Produktdatenqualität hilft, diese Probleme zu lösen. Durch eine vollautomatische Qualitätsanalyse zeigen wir einerseits auf, wo Defizite und Einsparpotenziale liegen, empfehlen aber andererseits auch Schritte zur Lösung der Probleme.

Welche Arten von Produktdaten werden für die Analyse der Datenqualität verwendet?

Produktdaten werden in der Regel in bestimmten Systemen gespeichert, z. B.

- Produktinformationsmanagement (PIM)-System

- Stammdatenmanagement (MDM)-System

- Produktdatenmanagement (PDM)-System

- Produktlebenszyklus-Management (PLM)-System

Aufgrund der Verbreitung von Dienstleistungen in der heutigen digitalen Welt gibt es jedoch weitere Quellen, die in die Qualitätsprüfung einbezogen werden können. Diese Systeme enthalten in der Regel auch Produktinformationen, die möglicherweise nicht in ein standardisiertes Produktinformationssystem zurückgeführt werden. Beispiele hierfür sind:

- E-Commerce-Systeme

- Logistik-Systeme

- Inhaltsverwaltungssysteme

- … und viele mehr.

Ursachen von geringer Datenqualität

Doch wie kommt eine niedrige Datenqualität bei Daten zu Stande? Es gibt eine Bandbreite an Gründen, die meist auch interagieren:

Legacy-Daten aus Legacy-Systemen

Stammdaten wie Kundendaten oder Produktdaten sind meist einer der ersten Datensätze in jedem Unternehmen. Und da sie zentral für die Kundenbetreuung, Produktentwicklung und Verkäufe sind, werden sie auch meist mit in neue Systeme migriert. Die Konsequenz sind veraltete Formate, fehlende Felder, falsche Datentypen und vieles mehr.

Der Faktor Mensch

Stammdatensystem werden meist durch Menschen befüllt. Egal ob von extern (z.B. Kunden) oder einem internen Mitarbeiter (z.B. Produktdaten): Menschen machen Fehler. Und diese Fehler spiegeln sich in der niedrigen Datenqualität wieder.

Fehlendes Bewusstsein

Meistens ist das Hauptproblem, dass nicht klar ist, wie wichtig Daten überhaupt sind. Ob für Kundenservice oder Datenanalysen: Sie brauchen gute, saubere Daten. Doch selten wird Data Governance als zentral für ein Unternehmen gesehen, weshalb schlechte Datenqualität selten korrigiert wird.

Ziel einer Ad-Hoc Datenqualitätsanalyse

Doch wie geht man die Korrektur schlechter Daten an? Als erstes empfiehlt sich, die Datenqualität umfassend zu überprüfen. Oft ist unklar, wie schlecht die Qualität wirklich ist und woran es genau fehlt. Es ist eine „gefühlte“ Datenqualität, die aber kaum belegt ist.

Hier kommen Datenqualitätsanalysen ins Spiel. Eine dedizierte Ad-Hoc Analyse der Datenqualität erlaubt es, genau festzustellen, welche Ansatzpunkte zur Verbesserung es gibt.

Egal ob als Data Scientist vor einer Analyse oder Berater vor einer CRM-Umstellung: Sich klar zu sein, welchen Zustand die Daten haben, ist fundamental. Doch dies ist oft mit hohem (manuellen) Aufwand verbunden. Deshalb haben wir ein Produkt entwickelt, das die Datenqualitätsanalyse automatisiert durchführt.

Automatische Datenqualitätsanalyse mit Kobold AI: Vorgehen und Ergebnis

Unsere automatisierte Datenqualitätsanalyse untersucht mehrere Faktoren von schlechter Datenqualität. Alle haben gemein, dass sie Hinweise darauf geben, welche Qualität die einzelnen Attribute haben und ob der nächste Schritt – die Korrektur – sinnvoll ist. Folgende Analysen führen wir durch:

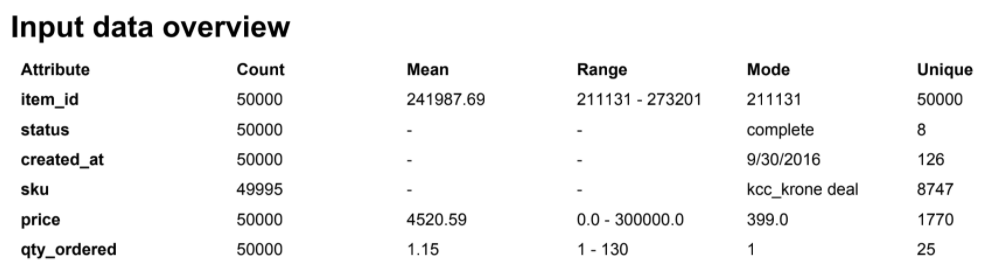

Initiale Datenanalyse: Einfache Statistik als Überblick

Als gutes erste Indiz für schlechte Qualität ist die Untersuchung der Attribute auf Inhalt. Dazu führen wir eine initiale Datenanalyse durch. Anzahl an Werten, deren Durchschnitt (Mean / Median), die Spannweite (Range) und wie viele einzigartige Werte sich darin befinden. Bereits diese einfache Analyse kann Hinweise geben, wenn ein Attribut anders befüllt ist als erwartet (z.B. falsche Spannweite durch Ausreißer, mehr einzigartige Werte als erwartet).

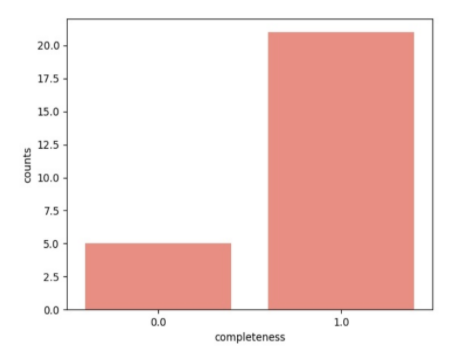

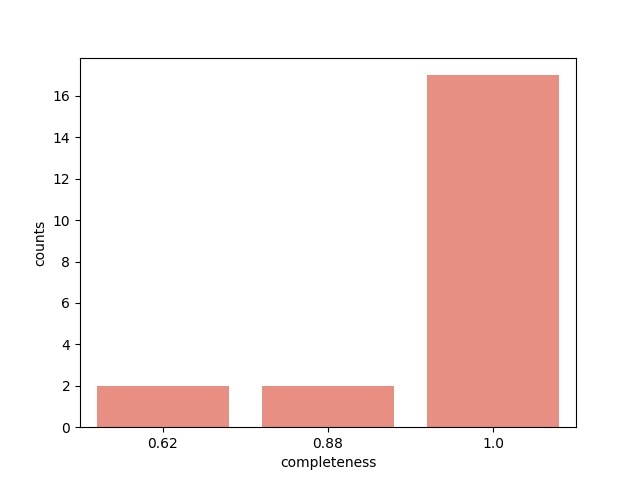

Datenvollständigkeit: Klare Interpretation ermöglichen

Das nächste Datenqualitätsattribut ist die Vollständigkeit jeder Spalte. Hierzu werden leere Felder gezählt und prozentual auf die Gesamtanzahl umgelegt. Generell sollte die Completeness in einem hoch qualitativen Datensatz bei 100% liegen, so dass keine leeren Felder auftreten. Doch muss hier Vorwissen zu den Daten eingesetzt werden, da gewisse Attribute teilgefüllt sinnvoll sein können (z.B. “Doktortitel”).

Da leere Felder schwierig zu interpretieren sind (Keine Angabe? Fehlende Angabe? Fehler im Übertrag?), sollten sie für eine hohe Datenqualität mit Platzhaltern gefüllt werden (z.B. “NA”, “no value”, “0”).

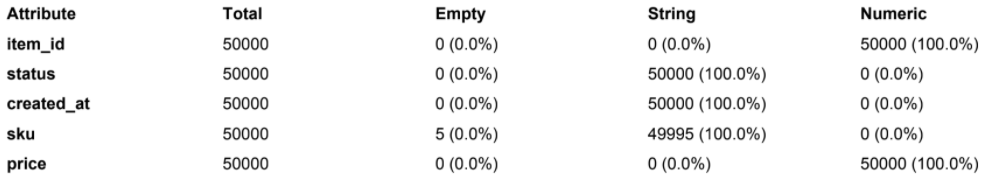

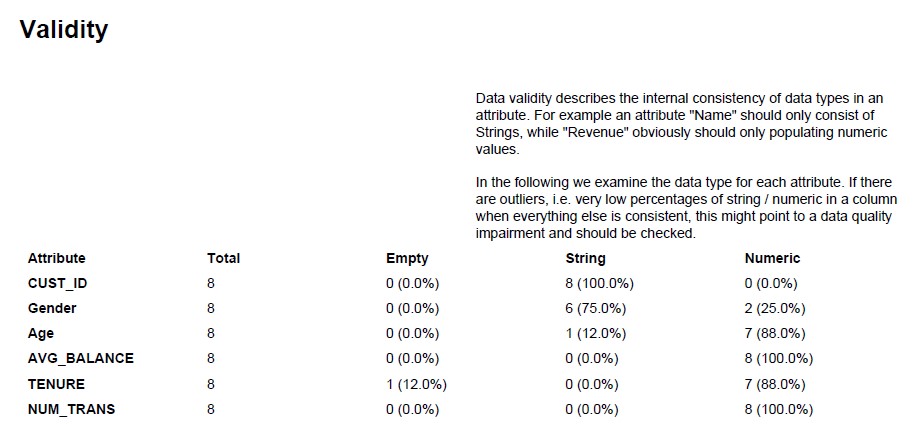

Data Validity: Zur Überprüfung von Datentypen

Die nächste wichtige Metrik sind Datentypen. Wenn ein Attribut zum Beispiel numerischen Inhalt beinhalten soll, aber auch Text aufweist, ist das ein Indiz für schlechte Datenqualität.

Daher prüfen wir die Data Validity, also die Verteilung von leeren, Text und numerischen Inhalten für jedes Attribut. Widerspricht ein Eintrag der Erwartung, muss dem nachgegangen und die fehlerhaften Werte korrigiert werden.

Dubletten: Doppelte Einträge identifizieren

Data Sparseness, also die Datensparsamkeit ist ein weiteres Attribut von hoher Datenqualität. Im Falle von Duplikaten bzw. Dubletten hat dies auch klare Kosten- und Kundennutzen. Wenn zum Beispiel ein Kunde mehrfach erfasst ist, kann es sein, dass es Probleme in der Lieferabwicklung und Rechnungsstellung gibt. Oder der Kunde wird mehrfach mit Marketingmaterial überhäuft.

Daher prüfen wir für jeden Eintrag im Datensatz, ob ein Duplikat existiert. Da es relativ selten ist, dass es exakte Duplikate gibt, gehen wir einen Schritt weiter und untersuchen auch die Duplikate bei Ausschluss eines Attributs. Folglich können auch “verdeckte” Dubletten erkannt und korrigiert werden.

Doppelte Attribute: Datensparsamkeit fördern

Doppelte Einträge sind ein Problem für Prozesse, doppelte Attribute hingegen für Systeme und Datenhaltung. In dieser Analyse stellen wir fest, ob es für Spalten im Datensatz identische Inhalte gibt.

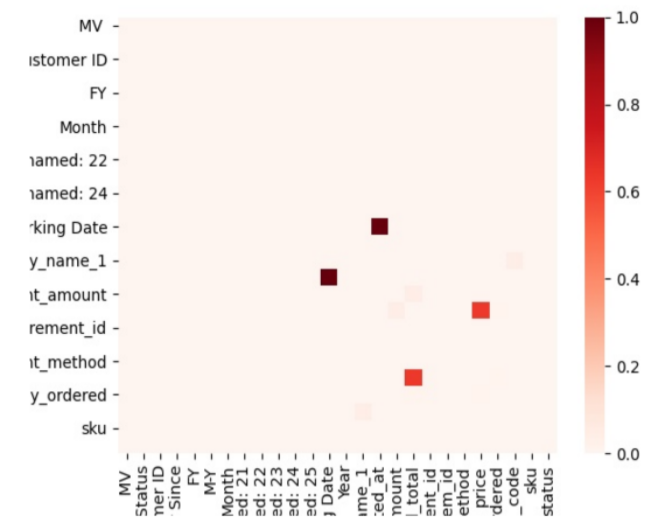

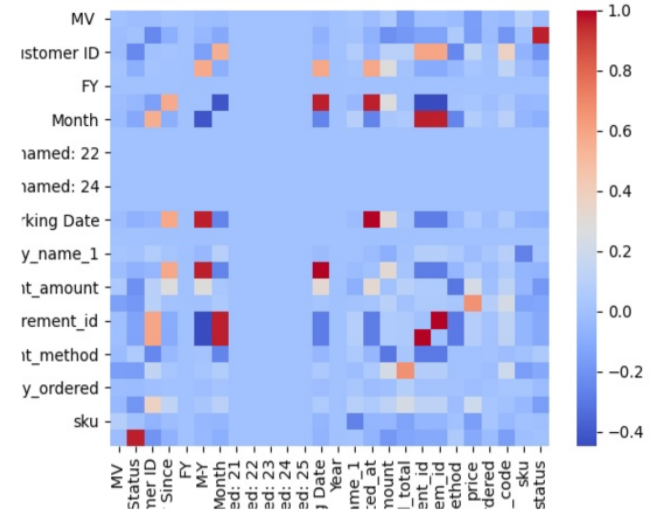

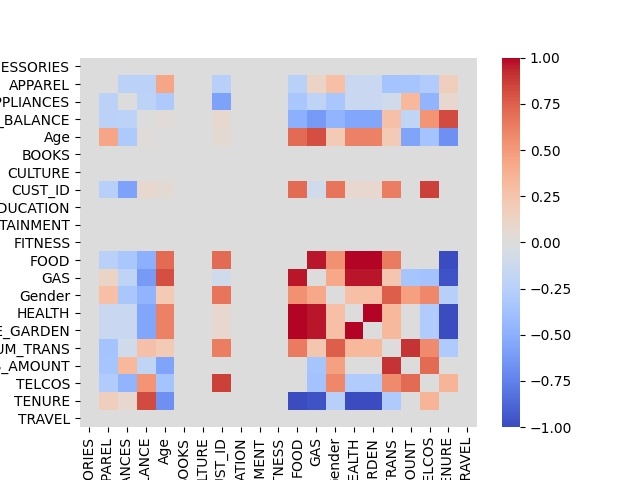

Datenredundanz: Ähnliche Attribute evaluieren

Während die doppelte Spaltenerkennung nur identische Werte findet, gehen wir in der Datenredundanz-Analyse weiter und untersuchen die Kundendaten auf Spalten, die sehr stark miteinander korrelieren, also die gleichen Werte ausweisen.

Der Unterschied zu doppelten Spalten ist, dass der Inhalt nicht identisch sein muss, aber zwei Werte immer gleichzeitig auftreten, was eine Redundanz darstellt (zum Beispiel Gewicht in Kilogramm und Gewicht in Gramm).

Datengenauigkeit: Ausreißer erkennen

Aufbauend auf initiale Analyse untersuchen wir in der Data Accuracy ob die realen Werte unserer Erwartung entsprechen. Vor allem im Bezug auf Werteverteilungen, Ausreißerhäufigkeiten und Beispielen untersuchen wir die Qualität.

Findet man beispielsweise unerwartet hohe Werteverteilungen (zum Beispiel Warenkorbwert im E-Commerce) oder viele Ausreißer, muss man sich Gedanken über die Herkunft und ggf. Auswirkung auf Reporting und Finanzen machen.

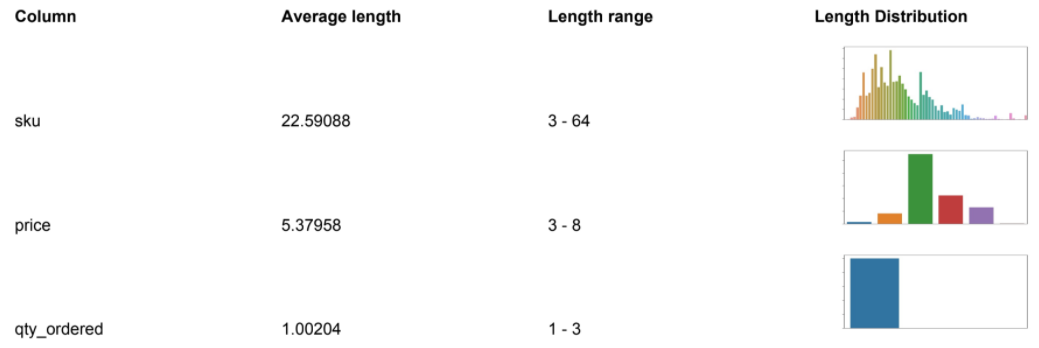

Datengenauigkeit: Länge als Inhaltsqualität

Abschließend nutzen wir noch die Zeichenlänge jedes Attributs, um zu untersuchen, ob die Werte unserer Erwartung entsprechen. Vor allem bei standardisierten Daten sollte eine Abweichung Alarmglocken anwerfen. Ein 20-stelliger Preis? Eine ISBN die nicht 13 Stellen lang ist? Ein Vornamen-Feld mit nur einem Zeichen?

Schnell erkennt man, wie einfach nur die erwartete Spannweite und durchschnittliche Länge eines Attributs ein klarer Hinweise auf schlechte Kundendatenqualität sein kann.

Self-Service KI mit Kobold AI: Wie es funktioniert

Kobold AI ist eine Self-Service Plattform für KI-Produkte. Das heißt, jeder Besucher kann unsere standardisierten KI-Produkte wie die Datenqualitätsanalyse einfach und ohne Hürden bestellen. Es werden eigene Daten bereitgestellt, durch diese eine individuelle Analyse erfolgt und direkt im Postfach des Kunden landet.

Wie funktioniert Self-Service KI mit Kobold AI?

Kobold AI macht künstliche Intelligenz zugänglich für Nicht-Experten. Auf unserer Online-Plattform werden KI-Produkte und deren Mehrwert erklärt und können einfach durch einen Klick bestellt werden. Durch die Bereitstellung der eigenen Daten werden automatisiert individuelle Ergebnisse geliefert.

Der Vorteil zu anderen Vorgehensweisen im Bereich künstliche Intelligenz ist kein Aufwand für Integration, kein notwendiges Datenexperten-Wissen und eine schnelle, günstige Abwicklung. Einfach bestellen, Ergebnisse bekommen.

Erwartete Eingabe

- Spalten: Beliebige Anzahl von Attributen

- Zeilen (max. 50.000): Eine pro Entität (Kunde/Partner/Nutzer/Produkt/Einsatz,..)

Beispiel für eine Datenqualitätsanalyse

Beispielbericht für die Analyse von Datenqualität herunterladen

Der nächste Schritt: Erhöhung der Datenqualität

Hat man die Datenqualität seiner Daten analysiert, bleibt selbstverständlich der nächste Schritt: Die Interpretation und anschließende Verbesserung der Daten. Hierzu sehen wir drei generelle Ansatzpunkte:

- Awareness schaffen: Die Datenqualitätsanalyse erlaubt es, im eigenen Unternehmen klar zu machen, weshalb es ein Problem mit der Datenqualität gibt. Folglich kann man damit Buy-In einholen, sich um die Verbesserung zu kümmern.

- Monitoring: Ein automatisches Monitoring oder eine regelmäßige Datenqualitätsanalyse erlaubt es, kontinuierlich informiert zu sein falls sich die Qualität verschlechtert. Somit weiß man früh, welche Probleme sich ergeben.

- Prozesse: Am wichtigsten ist die Einführung von datenqualitätserhöhenden Prozessen. Sei es durch Software wie beschränkte Eingabefelder (z.B. Dropdown statt Freitext) oder klare Richtlinien was bei leeren Feldern hinterlegt werden soll / muss; beides erlaubt ein “First time right” – also eine korrekte Eingabe – zu gewährleisten.

Vorteile der Datenqualitätsanalyse von Produktdaten

Einer der Hauptzwecke von Produktdaten ist die „Grundwahrheit“ von Produktinformationen. Als solche werden sie in der Regel sowohl über analoge (z.B. Katalog) als auch über digitale (z.B. Online-Shop) Kanäle verbreitet.

Wenn die Daten, die verteilt werden, von geringer Qualität sind, hat dies grundlegende Auswirkungen. Falsche Produktangaben (z.B. Farbe oder Größe) sind lästig, aber doppelte Einträge oder falsche technische Informationen können schnell zu hohen Kosten führen.

Daher ist eine hohe Produktqualität der Daten eine Notwendigkeit. Sie ermöglicht es Unternehmen, ihre Produktinformationen konsistent und zuverlässig zu verbreiten. So ist sichergestellt, dass Kunden immer korrekt informiert sind und bei einer Bestellung keine negativen Erfahrungen machen.

Darüber hinaus stellt sich insbesondere bei der Migration von Produktdaten von einem System in ein anderes meist die Frage nach der Datenqualität. Daher ist es sinnvoll, bei einem solchen Übergang die Datenqualität zu analysieren und zu verbessern, um zu vermeiden, dass Probleme in ein neu eingeführtes System übernommen werden.

Du musst angemeldet sein, um eine Bewertung abgeben zu können.

Ähnliche Produkte

-

Vorhersage von Servicefällen (30 Tage)

299,00 €exkl. 19 % MwSt.

-

Sentiment-Analyse

229,00 €exkl. 19 % MwSt.

-

Datenqualitätsanalyse für PIM-Daten

299,00 €exkl. 19 % MwSt.

-

Vorhersage der Besucheranzahl (30 Tage)

299,00 €exkl. 19 % MwSt.

-

Prognose E-Commerce Umsatz (30 Tage Forecasting)

299,00 €exkl. 19 % MwSt.

-

Analyse von verlorenen Wiederkäufern

349,00 €exkl. 19 % MwSt.

Bewertungen

Es gibt noch keine Bewertungen.