Was ist Big Data? Big Data ist eine Bezeichnung für Daten, die wegen Umfang oder Komplexität nicht einfach verarbeitbar sind. Der Ursprung des Begriffs stammt aus der Zeit als Datenmengen so groß wurden, dass sie nicht mehr lokal – also einem Computer – verarbeitet werden konnten.

Schnell wurde der Begriff “Big Data” um weitere Attribute erweitert: Von verschiedenen Datentypen (z.B. unstrukturierte Daten wie Bilder) über sich schnell ändernde Daten bis hin zum “Wert” des Datensatzes gab es viele Merkmale weshalb Daten umfangreich waren. Zusammen steht Big Data inzwischen mehr für eine neue Ära von Daten und Datennutzung, als nur die Menge an Daten.

Das hat zur Folge, dass der Begriff heute für eine ganze Reihe an Technologien, Algorithmen und Digitalisierungsideen genutzt wird. Von Infrastruktur über Machine Learning bis zu Cloud Computing fällt so ziemlich alles in “Big Data”. Wir möchten diesen Schleier etwas entzerren, indem wir darstellen wie Big Data – also die Daten an sich – definiert werden, welche Technologie man zur Aufnahme, Speicherung und Analyse einsetzt und welche Rollen daran beteiligt sind.

Inhaltsverzeichnis

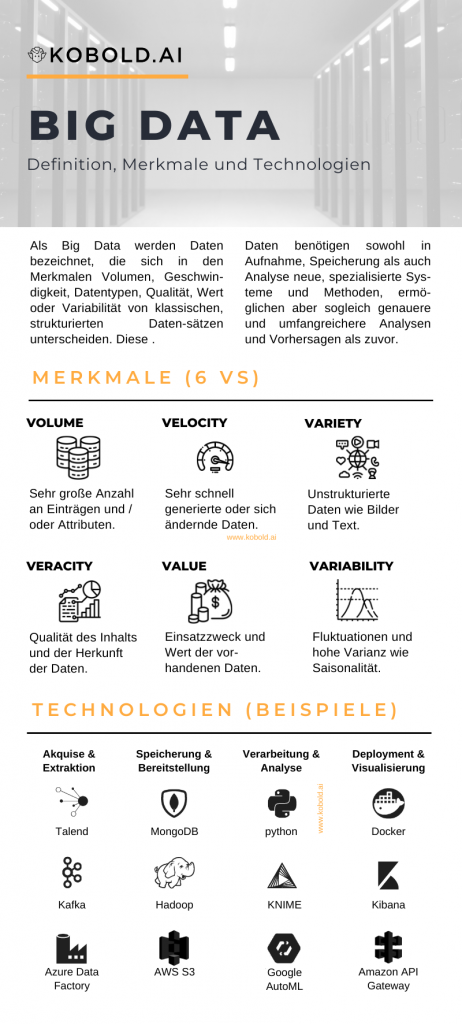

Big Data Infografik

Merkmale für Big Data: 3 Vs, 4 Vs, 5 Vs, 6 Vs, 10 Vs und mehr

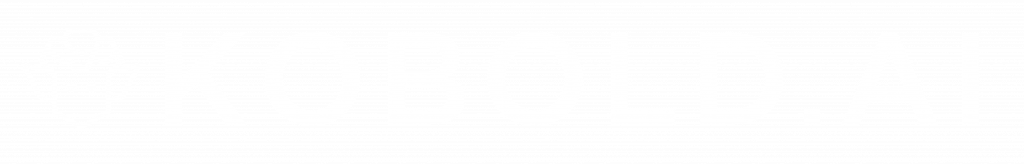

Wie eingangs angemerkt, kam der “Big”-Begriff vom Umfang, der Masse an aufkommenden Daten. Dabei gab und gibt es keine magische Grenze, ab wann Daten als “groß” gelten, sondern es sind vielmehr Merkmale der Eigenschaften von Daten. Daher ist Volumen inzwischen auch nur noch eine eine von vielen Ausprägungen, was alles als “Big Data” definiert wird und welche Attribute dabei zu beachten sind. Als Leitlinie zur Definition von Big Data haben sich die “Vs” etabliert, die von initial 3 Vs auf inzwischen bis zu 10 Vs angewachsen sind.

Volumen: Die Masse an Daten

Das Volumen ist einer der Faktoren, die wohl am grundlegendsten die neuen notwendigen Strategien für die Datenaufnahme und -verarbeitung beeinflusst haben. Dass es inzwischen immer mehr Datensätze gibt, die lokal nicht mehr erfasst, gespeichert oder analysiert werden können, ist auch offensichtlich. Folglich benötigt man rein für die Speicherung dieser Datenmengen neue Systeme, neue Methoden und somit neue Technologien.

Ganz konkret wird oft von “großen” Datenmengen gesprochen, wenn mehrere Gigabyte an strukturierten Daten vorliegen oder mehr als ein Terabyte an unstrukturierten Daten. Ganz offensichtlich nimmt mit zunehmendem “Volume” auch die Notwendigkeit für Speziallösungen zu. Als eines der prominentesten Beispiele gilt wohl der Einsatz eines Hadoop-Systems zur Verarbeitung großer Datensätze auf verteilten Systeme.

Als einfachstes Beispiel für Big Data Volume ist das Internet of Things (IoT). Im Internet der Dinge produziert jedes technologisches Gerät Daten – in großer Menge. Diese Daten von den sogenannten Edge Devices zu erfassen und zu speichern ist nach wie vor eine große Herausforderung für viele in die Jahre gekommenen IT-Infrastrukturen (Legacy Systems).

Variety: Die Varianz der Datentypen

Neben dem Volumen war die aufkommende Vielfältigkeit (Variety) der erfassten Daten ein Grund, spezielle Datensätze speziell zu behandeln. Schätzungen zufolge sind etwa 80% der Daten unstrukturiert, vor allem Text und Sprache, aber zunehmend auch Bild und Video beinhaltet große Informationen. Während es vor wenigen Jahren maximal in der wissenschaftlichen Forschung Usus war, diese hohe Varianz an Datentypen zu verarbeiten, ist es heute ein Standard.

Bei breiterer Auslegung des Merkmals betrachtet man auch die Vielfältigkeit der Herkunft der Daten. Dass inzwischen nicht mehr nur ERP-Systeme Daten liefern, sondern jede Art von Kanal Daten zur Verarbeitung produziert, ist sehr offensichtlich. Dass diese Systeme auch auf unterschiedlichste Arten die Daten liefern ist ein weiterer Aspekt in der “Big Data” Landschaft. Daher ist die Variety eine der grundlegendsten Veränderungen in der Verarbeitung von Daten.

Ein sehr schönes Beispiel für die Big Data Variety ist der Bereich des Text Minings. Erst durch das Aufkommen von Sozialen Netzwerken gibt es die Möglichkeit, direkt von Nutzern in sehr umfangreicher Zahl textuellen Input zu analysieren. Die wohl bekannteste Methode ist hierbei die Sentimentanalyse, die Texte, Nutzer und Statements auf ihren emotionalen Gehalt – also positiv, neutral oder negativ – untersucht.

Velocity: Die Geschwindigkeit der Daten

Das dritte initiale Merkmal war die Geschwindigkeit der Daten, die Big Data Velocity. Von Generierung über Analyse bis zu Änderungen sind alle Aspekte im Datenkreislauf von dieser erhöhten Geschwindigkeit betroffen. Wenn Daten sehr schnell erzeugt werden, wird es auch immer wichtiger, technologische Lösungen gegen Doppeleinträge, Datenbanksperren und Ausfallsicherheit zu finden.

Neben diese mikroskopischen technischen Level gibt es auch das makroskopische Ansicht der Analyse: Wenn sich Daten sehr schnell anhäufen oder ändern, müssen auch Analysen entsprechend flexibel reagieren können. Dies bedeutet schnelle, umfassende Extraktion, Analyse und Ausspielung der neuen Erkenntnisse. Velocity bedeutet also, dass neue technische Lösungen und Methoden gefunden werden müssen, um schnell generierte Daten zu erfassen und zu analysieren.

Als Beispiel für Big Data Velocity kann man den Datensatz eines Kunden nehmen, der über alle Kanäle eines Unternehmens erfasst und angereichert werden muss. Wenn ein Kunde ein Problem innerhalb der App eines Unternehmens hat, dort Aktionen vornimmt, danach über das Callcenter mit dem Service telefoniert, sollten all diese Daten direkt und sekundengenau erfasst und konsolidiert werden.

Veracity: Die Qualität und Herkunft der Daten

Neben den 3 Vs, gibt es auch die Erwähnung von 4 Vs, 5 Vs oder 6 Vs. Als viertes V kam Veracity hinzu. Mit dieser “Verlässlichkeit” der Daten ist gemeint, in welchem Ausmaß der Herkunft und der Qualität der Daten vertraut werden kann.

Als Faktor der Herkunft ist sowohl Dokumentation als auch Vertrauenswürdigkeit der Quelle gemeint. Nur wenn die Daten aus Systemen oder von Personen kommen, die als vertrauenswürdig eingestuft werden, können sie zur Verwendung eingesetzt werden. Im gegenteiligen Fall wären die Daten im schlimmsten Fall frei erfunden und würden somit keinen Wahrheitsgehalt beinhalten.

Die Qualität der Daten ist ein weiterer kontinuierlicher Begleiter in der Welt der Datenanalyse und des Machine Learnings. Nach dem “Garbage in, garbage out”-Prinzip kann eine Analyse nur dann sinnvollen Output liefern, falls der Algorithmus qualitativ hochwertige Daten geliefert werden. Diese Qualität bezieht sich auf Faktoren wie Korrektheit, Relevanz, Komplettheit und andere. Somit qualifiziert die Veracity Daten eigentlich erst für die weitere Verarbeitung.

Als Beispiel für Big Data Veracity gilt die Dokumentation eines aggregierten Datensatzes im eigenen Data Lake. Nur wenn klar ist, aus welchem System die Rohdaten kamen, wie sie auf Qualität geprüft und korrigiert wurden und wie sie aggregiert gespeichert worden sind, sind sie zur weiteren Verarbeitung geeignet. Liegen diese Informationen nicht vor, ist es ein unverlässlicher Datensatz mit zu vielen Unbekannten.

Für noch mehr Details zur Big Data Veracity besucht unseren Artikel “Big Data Veracity: Definition und Beispiele”.

Value: Der Wert der Daten

Während die ersten vier Big Data Vs eher technischer Natur sind, kam mit dem fünften V, dem Value (Wert), ein interpretativer Faktor hinzu. Was bringen große Datenmengen, die von hoher Qualität sind, wenn sie keinerlei Nutzen haben?

Mit zunehmendem technischen und budgetären Aufwand für die Umsetzung für Big Data Infrastruktur und Personal kam berechtigterweise verhäuft die Frage: Brauchen wir diese Daten und Analysen überhaupt? Die Antwort auf diese Frage bildet das Big Data Value ab: Gibt es einen Wert der vorliegenden Daten?

Ganz simplifiziert gesprochen können Daten in unendlichem Ausmaß aufgezeichnet werden. Jedes System – Menschen eingeschlossen – die Daten produzieren, werden in ihrer Datenproduktion nur durch die Abtastrate gesteuert. Wenn ich diese nun mit der Annahme erhöhe, dass feingranulare Daten einen höheren Wert haben, ist dies ein Argument für die zusätzlichen Aufwände für Infrastruktur und Algorithmen. Falls nicht – dann ist das Value eben gegebenenfalls nicht ausschlaggebend genug.

Als Beispiel für die Frage nach Big Data Value können viele generierte Sensordaten gelten. Nur weil ein System im Stande ist Daten in sehr hoher Menge und Geschwindigkeit zu erzeugen, bedeutet dies nicht, dass diese Daten auch eine Relevanz besitzen. Man muss also abwägen zwischen dem Speichern von allen und dem Speichern von nutzbringenden Daten, den sogenannten Smart Data.

Für noch mehr Details zum Big Data Value besucht unseren Artikel “Big Data Value: Was ist das?”.

Variability: Die Varianz der Daten

Als sechstes etabliertes V gilt die Variability, also sich ändernde Daten. Während Variety auf die Datentypen eingeht, Veracity auf die Herkunft, beschreibt dieses V die Kontinuität der Datensätze. Ein variabler Datensatz ist von einer hohen Varianz gekennzeichnet, die sich über Zeiträume oder Segmente abspielt. Als verständliches Beispiel gilt eine zeitliche Variability, die Saisonalität.

Wer mit sich saisonal verändernden Daten arbeitet, bei dem verändern sich sowohl die Anforderungen an die Infrastruktur als auch die Verlässlichkeit der Analyse. Speziell im Machine Learning ist die Zeit als Faktor in Zeitreihenanalysen (Time Series Analyses) ausgeprägt. Aber auch für klassische deskriptive Analysen ist eine hohe Varianz von Daten ein großer Faktor: Mittelwerte sind schnell nicht mehr aussagekräftig, wenn sie eine hohe Standardabweichung besitzen.

Das bekannteste Beispiel für Big Data Variability, also eine hohe Varianz an Daten und Saisonalität, ist vermutlich Weihnachten. Es gibt ganze Unternehmenskategorien die vom Weihnachtsgeschäft abhängig sind und in diesen Monaten mehr Umsatz machen als auf das gesamte restliche Jahr kombiniert. Würde man nun Daten aus solchen Monaten als Grundwahrheit betrachten und die zeitliche Komponente (Saisonalität) ausser Acht lassen, würden schnell falsche Schlüsse in Analysen gezogen werden.

8 Vs, 10 Vs, 42 Vs …

Aber damit nicht genug. Über die letzten Jahre kamen immer mehr V-Listen, von 8 Vs über 10 Vs bis hin zu 42 Vs auf. Diese möchten wir ergänzend hier aufführen, dazu allerdings sagen, dass solche Begrifflichkeiten sehr variabel und nicht in dem Maß etabliert sind, wie die 6 Big Data Vs. Weitere Vs sind zum Beispiel:

- Visualization: Oft der einzige und daher sehr wichtige Kontaktpunkt zwischen technischer und Business-Seite.

- Volatility: Egal wie gut man Daten säubert und vorbereitet, kann es immer sein, dass sich plötzlich einzelne Inhalte oder Datenattribute ändern. Dies führt besonders in operationalisierten Modellen zu Problemen.

- Vagueness: Die Dokumentation und Bedeutung von vorliegenden Daten ist oft sehr unklar.

- Validity: In der Analyse müssen strenge Regeln (z.B. Voraussetzungen für statistische Tests) beachtet werden, sonst werden Ergebnisse ungültig.

- Varmint: Umso größer die Daten, umso größer auch das Potential für Probleme in der Softwareentwicklung.

- Visibility: Die Datenwissenschaft bietet Einblick in komplexe große Datenprobleme.

- Vivify: Data Science und Big Data sind Methoden und können somit auf alle Arten von Problemen, Prozessen und Optimierungen angewandt werden.

- Voodoo: Big Data und Data Science werden oft als Voodoo gesehen – wichtig ist eine enge Bindung an Stakeholder und Kunden, um den Wert dieser Arbeit zu vermitteln.

- Viability: Es ist schwierig, robuste Modelle zu erstellen, und noch schwieriger ist es, Systeme zu bauen, die sich in Produktion bewähren.

- Vastness: Die Kombination von Volume und Velocity. Mit IoT, dem Internet der Dinge, nehmen beide Merkmale exponentiell zu.

- Vantage: Big Data und Künstliche Intelligenz ermöglichen uns einen privilegierten, abstrakten Blick auf komplexe Systeme.

- Vanilla: Auch einfache Analysen und Modelle können einen hohen Wert liefern.

- Verdict: Immer mehr Menschen sind von Big Data Analytics betroffen. Umso wichtiger sind andere Vs wie Veracity und Validity.

- Version Control: Technisch gesehen müssen mit zunehmender Professionalisierung der Analysemethoden auch professionelle Softwaremethoden übernommen werden.

- Vibrant: Die Neugierde, Daten zu verarbeiten, ist wichtig und bildet die Basis für neue Ideen, Herangehensweisen und Unterstützung bei “data driven” Arbeit.

- Viral: Wie verbreiten sich Daten unter anderen Nutzern und Anwendungen?

- Vault: Durch die Nutzung von immer mehr Daten nimmt auch die Nutzung von sensiblen Daten (z.B. DSGVO-relevante Daten) zu. Datensicherheit wird daher immer zentraler.

- Valor: Man muss den Mut aufbringen, sich in große Datenmengen zu stürzen um auch die großen Probleme dieser Welt angehen zu können.

- .. und viele mehr

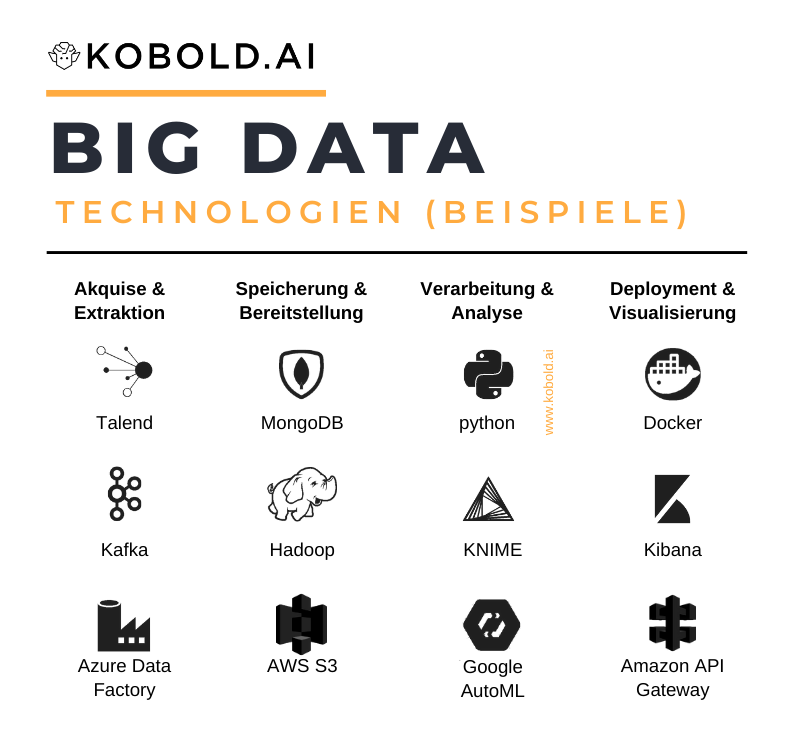

Big Data Technologien und Tools: Ein Auszug

Wie eingangs erwähnt, ist Big Data ein Begriff für ein Konglomerat an Technologien, Methoden und Ideen. Während wir bisher auf die Merkmale von großen Daten eingegangen sind, möchten wir uns im Folgenden auf Big Data Technologien konzentrieren. Durch das Aufkommen an großen Datenmengen und die Bereitschaft zu deren Analyse hat sich in den letzten Jahren die Landschaft an Systemen und Tools massiv verbreitert. Aufgrund dieser schieren Masse können wir hier auch nur einen gewissen Auszug an Technologien vorstellen, die nachfolgenden Auszüge erheben daher keinen Anspruch auf Vollständigkeit.

Datenakquise & ETL

Der erste Schritt in der Datenverwertungskette ist selbstverständlich die Aufnahme, Erfassung und Extraktion von Daten. Herkömmliche Extrakte wie FTP-Datendumps oder ähnliches sind in vielen Fällen nicht mehr praktikabel, da sie sowohl von Volumen als auch Geschwindigkeit nicht mit moderner Infrastruktur Schritt halten können. Folglich haben sich moderne Big Data Technologien entwickelt, die neue Prinzipien realisiert.

Ein Fokus ist die Extraktion von Daten aus einem Quellsystem, gegebenenfalls mit zugehöriger Transformation und Kombination und das folgende Ausspielen in ein Zielsystem. Dieser Extract-Transform-Load (ETL) Prozess wurde und wird häufig mit Code realisiert, was allerdings zu niedrigerer Pflegbarkeit führt, sowie auch jede dieser Data Pipelines neu anlegt. Als Lösung für diese immer häufig auftretende Aufgabe im Bereich der Data Engineers gibt es ETL-Tools wie Talend oder Pentaho. Beide haben sich darauf spezialisiert, eine Vielzahl an Standardkonnektoren zu entwickeln, um möglichst einfach und direkt an Systeme angeschlossen werden zu können. Dies gilt sowohl für das Einlesen als auch Ausspielen von Daten.

Zwischen diesen Schritten liegt die Stärke dieser ETL-Systeme: Mittels definierter Regeln werden die extrahierten Daten transformiert, gegebenenfalls kombiniert und schlussendlich bereit gestellt. Beide Plattformen haben auch enge Verbindungen zum Thema Data Governance, um beispielsweise Datenqualität zu analysieren und korrigieren, was eine immer höhere Relevanz in jeder Data-Driven Company einnimmt.

Auf der anderen Seite spielt die Geschwindigkeit von Big Data, also die Velocity, eine immer größere Rolle. Während vor ein paar Jahren Updates “über Nacht” der Standard waren, leben wir in einem Zeitalter in dem wir auf Millisekunden Basis, also Real-Time, Daten erheben und verteilen möchten. Dies gilt sowohl für die Akquise von Daten, als auch für die Verteilung an weiterverarbeitende Systeme wie Machine Learning Modelle oder Visualisierungen. Dafür wurden Stream-Plattformen wie Kafka oder Spark entwickelt, die dem noch immer herkömmlichen Batch-Processing mit einer Kette an Daten-Events entgegen treten, um sie kontinuierlich zur Verfügung zu stellen.

Datenspeicherung

Sind die Daten akquiriert, müssen sie auch in einer Datenbank persistiert werden. Klassische SQL-basierte relationale Datenbanken schaffen es in der Big Data Umgebung nicht mehr mitzuskalieren. Als Lösungen wurden verteilbare “Not only SQL”-Systeme entwickelt, namentlich als Beispiele MongoDB oder Cassandra. Diese Infrastrukturen lassen sich vertikal skalieren, also auf viele verschiedene Server verteilen, um große Datenmengen abzudecken. Da dabei SQL-Zugriffe erhalten bleiben, erlauben diese Systeme einen sehr komfortablen, direkten und auch analytischen Zugriff für Konsumenten.

Als Alternative zu SQL-basierten Systemen hat sich das Hadoop Ökosystem entwickelt. Apache Hadoop ist ein auf Googles MapReduce Algorithmus basierendes Dateisystem, das massive, parallele Prozessierung von Anfragen erlaubt. Genauer wird es in drei Schritten realisiert: Zuerst werden Daten in das Hadoop Distributed File System (HDFS) geladen, dann mittels MapReduce-Operationen parallel verarbeitet, um die Ergebnisse wieder über HDFS auszuspielen.

Als dritten Weg, große Datenmengen zu handhaben, haben sich Cloud Services herauskristallisiert. Als Beispiele seien hier die AWS S3-Infrastruktur oder Google Big Query genannt. Diese und andere Dienste zeigen ihre Stärke einerseits in der serverless Struktur die eine nahtlose Skalierung erlaubt, andererseits in ihrer nahen integration zu vorgelagerten oder nachgelagerten Big Data Prozessen (z.B. ETL, Machine Learning, Visualisierung) innerhalb ihres Ökosystems.

Datenverarbeitung, -analyse & Machine Learning

Kommen wir zum Herzstück jedes Big Data Environments. Denn Unmengen an Daten, die sauber erfasst und gespeichert sind, müssen auch weiterverarbeitet werden, damit sie einen Mehrwert stiften können. Hier sind in einem großen Prozentsatz noch Programmiersprachen im Einsatz, da sie die feinste Steuerung der Prozesse erlauben. Betrachtet man beispielsweise einen einfacheren Verarbeitungsprozess, nämlich das Bereitstellen von vorbereiteten Daten zum Abruf via API oder ähnlichem, kommt meist der Allrounder Java zum Einsatz.

Umso weiter man sich allerdings von klassischer Softwareentwicklung wegbewegt, umso näher kommt man an spezialisierte Datensprachen wie python oder R. Diese sind durch ihre einfache Paketbasierung in der Lage, eine umfangreiche Bibliothek an Analyse und KI Algorithmen bereit zu stellen. Das Trainieren von Machine Learning Modellen ist somit auf die Parameteroptimierung konzentriert statt auf die Implementierung der Algorithmen. Zusätzlich kommen immer mehr spezialisierte Sprachen wie Scala oder neuerdings Julia auf den Markt, die noch mächtiger im Umgang mit großen Datenmengen sein sollen.

Neben diesem “Handwerk” hat sich allerdings auch eine Schiene der GUI-basierten Datenverarbeitungsprogramme entwickelt. Diese sollen den gesamten Datenkreislauf vereinfachen, indem sie modulare, konfigurierbare Bausteine zur Verfügung stellt, die vom Nutzer dann nur mittels Interface angeordnet und angepasst werden müssen. Der Vorteil ist selbstverständlich die niedrigere Einstiegshürde und die höhere Reproduzierbarkeit des Prozesses, der Nachteil die niedrigere Granularität und geringere Kontrolle über Details der Vorgänge. Beispiele hierfür sind die Freeware KNIME oder das kommerzielle Produkt RapidMiner.

Als dritte Schiene in der Datenverarbeitung haben sich Cloud-Anbieter etabliert. Lösungen wie Azure Machine Learning oder Google AutoML bieten inzwischen einen guten Zugang für Laien, während sie mächtige Konfigurations- und Erweiterungsmöglichkeiten für Experten bereitstellen. Die Kombination von niedriger Hürde mit guter Granularität der Einstellungen und der Hinblick auf vollautomatisierte Machine Learning Optimierung (AutoML) lässt darauf schließen, dass diesen Lösungen nach und nach die Zukunft in der Bandbreite der Anwendung gehören wird.

Operationalisierung & Datenvisualisierung

Die Daten sind akquiriert, gespeichert und verarbeitet. Im letzten Schritt müssen die Daten, Analysen oder Modelle aber noch ausgespielt werden. Entweder als direkte Datenlieferung, als Schnittstelle für andere Kanäle oder als Visualisierung der Ergebnisse für Konsumenten, also interne oder externe Kunden.

Ein Hauptthema ist das Bereitstellen von Analyseergebnissen bzw. die Anbindung von trainierten Modellen. Hierzu gibt es inzwischen eine Vielzahl an Lösungen, die erlauben Daten zu übermitteln und die entsprechenden Ergebnisse zurück zu bekommen. Als ein Beispiel gilt Docker. Mit dieser Lösung werden Container erstellt, die nicht nur das Analysescript und/oder Modell beinhalten, sondern auch alle dazu notwendigen Pakete, um das Script exakt wie entwickelt auszuführen.

Als Alternative – oder Kombination – werden direkt APIs erstellt und für andere Anwendungen bereitgestellt. Diese Strategie ist sehr häufig in Cloudumgebungen zu finden. Beispielsweise Amazon API Gateway oder Google BigQuery haben es sich innerhalb ihrer Domäne zur Aufgabe gemacht, nicht nur Daten zu speichern und Analysen zu entwickeln, sondern eben diese Erkenntnisse auch wieder auszuspielen.

Der häufigste Weg, verwertete Daten auszuspielen sind jedoch nach wie vor Visualisierungen. Die meisten Unternehmen befinden sich 2020 auf einem Stand der Digitalisierung, auf dem eine umfangreiche, nutzer-zentrische Visualisierungslandschaft noch in weiter Ferne ist. Doch Tools für das Vorgehen gibt es zu genüge: Von Tableau über PowerBI, MicroStrategy, Kibana zu IBM Cognos und vielen mehr haben sich immer mehr Visualisierungstools in der Big Data Landschaft etabliert, die einerseits sehr große Freiheit in der Gestaltung der Grafiken erlauben, andererseits eine Vielzahl an Konnektoren zu Daten- und Analyticsquellen bereitstellen. Die Herausforderung ist es nach wie vor eher, Daten bereit zu stellen und durch Analysen und Darstellungen “actionable Insights” – also Erkenntnisse, die nächste Schritte ableiten lassen – zu vermitteln.

Big Data Analytics: Die Analyse der Datenmengen

Im Prinzip gibt es drei Ansatzpunkte der Vs, um durch Big Data neue Erkenntnisse zu etablieren. Einerseits und bereits mehrfach angesprochen, ist der meist einzige und auch direkte Weg zu Stakeholdern die Visualisierung. Die Grundlage für die Wichtigkeit ist das Big Data Value: Wie können wir Daten vermitteln, damit Business Stakeholder “actionable Insights” erhalten.

Im Hintergrund steht klassische deskriptive Statistik und Business Intelligence. Dennoch gilt es auch solche “einfachen” Analysen nicht zu verachten. Zum einen sind sie die Basis für weitere Methoden, zum anderen ist es eine Kunst, mit einfachen Mitteln aus großen Datenmengen wichtige Erkenntnisse zu extrahieren. Dass dies schon lange ein relevantes Thema ist, sieht man daran, dass die meisten Firmen inzwischen Analytics oder Intelligence in einer Form etabliert haben. Nur die darunterliegende Technologie ist aufgrund des Volumen der Daten etwas anders geworden.

Machine Learning / Künstliche Intelligenz

Allerdings gibt es auch weitere Methoden, die bisher nicht herkömmlich genutzt wurden. Die erste Assoziation mit Big Data Analytics ist selbstverständlich das Machine Learning. Maschinelles Lernen ist ein Teil des Gebiets der künstlichen Intelligenz – kurz KI – und basiert auf statistischen Methoden, die schon lange etabliert sind. Doch erst durch die großen Datenmengen – das Big Data Volume – ist es möglich, diese Methoden effizient und nachhaltig anzuwenden.

Im Machine Learning, dem Herzstück der sogenannten Advanced Analytics, unterscheidet man zwischen drei Kategorien. Das Supervised Learning folgt dem Prinzip, dass man Trainingsdaten zur Verfügung stellt (z.B. Bilder sind in Kategorien geordnet) und diese einem statistischen Modell gelehrt werden. Ob dieses Modell nun eine einfache Regression, ein Entscheidungsbaum oder ein Neuronales Netz ist, ist im Endeffekt irrelevant – denn alle Methoden lernen eine Gewichtung der verschiedenen Attribute um möglichst oft die richtige Kategorie zu “erraten”. Hat man ein solches Modell mit den Trainingsdaten trainiert, werden neue Daten auf das Modell gelegt um zu validieren, wie gut es unterscheiden kann – die sogenannte Testphase.

Die zweite Kategorie im Einsatz von Artificial Intelligence in Big Data Analytics ist das Unsupervised Learning. Diese Methoden bekommen im Gegensatz zum Supervised Learning keinerlei Informationen bereit gestellt über “richtig” oder “falsch”, sondern optimieren inhärente Kategorien (z.B. wie ähnlich sind sich Kundengruppen) oder erkennen repetitive Muster (z.B. Warenkorbanalysen). Genauer spricht man hier meist von den Bereichen Clustering (Gruppierung ähnlicher Daten), Assoziationsanalyse (Erkennen von Regeln), Ausreißererkennung und Dimensionsreduktion. Alle Algorithmen haben gemein, dass sie ohne “Wissen” über Umwelt, Ergebnis oder Wahrheit, sondern rein datenbasiert agieren.

Die dritte formal geführte Kategorie ist das Reinforcement Learning (Bestärkendes Lernen). Hier interagiert ein Agent (ein Programm) mit einem Environment (einer Umgebung, repräsentiert durch Entitäten, die Effekte auslösen). Das Ziel des Agenten ist es, ein gewisses Ziel (optimal) zu erreichen. Dazu stehen ihm Aktionen zur Verfügung. Ein einfaches Beispiel wäre ein Staubsauger-Roboter, der zurück zu seiner Ladestation möchte, aber gegen die verschiedenen Hindernisse in einer Wohnung kämpfen muss. Seine Handlungsmöglichkeiten sind Bewegungen und Drehungen, sein Ziel ist die Minimierung der Zeit, das Environment ist repräsentiert durch die Sensoren des Roboters. Schon alleine an dieser kleinen Aufzählung merkt man, dass Reinforcement Learning erheblich aufwendiger ist als andere Machine Learning Methoden. Von daher sind diese meist auch nur in der Forschung eingesetzt, wenig in realen Produkten, da der zu implementierende und testende Aufwand meist nicht einem effektiven Nutzen gegenüber steht.

Beispiele für den Einsatz von Big Data bei Kobold AI

-

Bilder freistellen

Bilder freistellen -

Kaufzeitraum vorhersagen

Kaufzeitraum vorhersagen -

Dubletten entfernen

Dubletten entfernen -

Korrektur von Datenqualität

Korrektur von Datenqualität -

Produktbeschreibungen erstellen

Produktbeschreibungen erstellen -

Topic Modeling

Topic Modeling -

Best Price Prediction: Vorhersage von optimalen B2B-Angebotspreisen

Best Price Prediction: Vorhersage von optimalen B2B-Angebotspreisen -

Übersetzung Deutsch zu Englisch

Übersetzung Deutsch zu Englisch -

Sentiment-Analyse

Sentiment-Analyse -

Prognose E-Commerce Umsatz (30 Tage Forecasting)

Prognose E-Commerce Umsatz (30 Tage Forecasting) -

Demand forecasting (30 Tage Vorhersage)

Demand forecasting (30 Tage Vorhersage) -

Datenqualitätsanalyse für Service-Daten

Datenqualitätsanalyse für Service-Daten

Streaming Analytics

Eine weitere Besonderheit im Big Data Analytics ist On-Stream Analytics. Dieses Herangehen erlaubt es, Daten bereits zu analysieren, bevor sie wie oben beschrieben in einer Datenbank persistiert werden. Folglich gewinnt man bereits Einblicke in die Daten, bevor sie gespeichert – und dementsprechend extrahiert, analysiert und das Ergebnis weiterverarbeitet – wurden.

Das attraktive an diesem Vorgehen ist einfach gesprochen die Schnelligkeit der Ergebnisse im Vergleich zu herkömmlichen Big Data Analytics Methoden. Sofortige Analyse von generierten Daten erlaubt eine sofortige Reaktion in besonders kritischen Bereichen wie beispielsweise der Betrugserkennung einer Bank oder dem Infrastruktursicherheitsbereich großer IT-Unternehmen. Aber auch Marketing kann von direkter Kundenverhaltensanalyse profitieren, um beispielsweise direkt passende Empfehlungen in Form von Produkten auszuspielen.

Beteiligte Rollen in der Landschaft großer Daten

Dieser Artikel hat in Summe dargestellt worum es bei Big Data geht, wie die Infrastruktur dahinter aussieht und welche Analysemethoden man damit durchführen kann. Was fehlt – und darauf gehen wir in den nächsten Absätzen ein – sind die Rollen. Big Data Jobs werden immer zahlreicher und die wenigsten Firmen finden gewünschte Profile in ausreichender Menge. Daher eine kurze Kategorieübersicht über spezielle Rollen, die man in data-driven Organisations findet.

Data Architect Aufgaben

Der (Big) Data Architect, je nach Fokus auch Business Architect, Solution Architect oder Cloud Architect genannt, kümmert sich um die Planung der Infrastruktur. Seine Aufgaben umfassen:

- Definition der beteiligten IT-Systeme und einer Lösung für das Vorhaben

- Einbettung des Vorhabens in die IT-Landschaft des Unternehmens

- Erarbeitung und Umsetzung des Sicherheits- und Zugangskonzepts

- ggf. Erarbeitung von Datenmodellen und deren Einbettung in Data Governance-Konzepte

- ggf. Aufsetzen der Infrastruktur zur Inbetriebnahme

Big Data Engineer Aufgaben

Die Aufgabe des Data Engineers, auch Big Data Engineer, Cloud Engineer oder Software Engineer betitelt, ist das Bereitstellen von Daten für die weitere Verarbeitung. Genauer:

- ggf. Aufsetzen der vom Architekten definierten Infrastruktur, v.a. in einer Cloud-Umgebung wie Microsoft Azure, AWS oder Google Cloud

- Management und Pflege der eingesetzten Big Data Infrastruktur, Datenbanken und Clustern

- Erstellen von Pipelines um existierende Daten zwischen Systemen zu befördern und ETL-Prozesse zu etablieren

- Neudatenakquise via APIs, Crawling oder ähnlicher Methoden

- Deployment / Operationalisierung von Machine Learning Modellen und anderen Datenprodukten

Für noch mehr Details zum Rollenbild des Big Data Data Engineers besucht unseren Artikel “Data Engineer: Beschreibung, Aufgaben, Tools und Gehalt”.

Data Scientist Aufgaben

Als Data Scientist deckt man prinzipiell den gesamten Big Data Datenkreislauf ab. Von der Identifizierung des Datenpotentials über Identifikation der Datenquellen, Anbindung, Analyse und Modellierung bis zum Ausspielen des Mehrwerts ans Business: Als General Data Scientist ist man an allen Schritten beteiligt:

- Definition Big Data Potential anhand von Use Cases, Consulting zur Umsetzung

- Identifikation von Datenquellen und möglichen oder nötigen Inhalten

- ggf. Anbindung oder Erschließen der Datenquellen, wie der Data Engineer

- ggf. Deskriptive Analyse und statistische Auswertung, wie ein Data Analyst

- Advanced Analytics, insbesondere Big Data Analytics via Machine Learning Modellierung

- ggf. Ausspielen der Erkenntnisse via Model Deployment oder Visualisierungen

Weitere Big Data Rollen

Es gibt noch zahlreiche weitere Rollen wie zum Beispiel den Data Analyst, Machine Learning Engineers, einen Data Translator, Data Stewards und mehr. Diese werden allerdings nicht direkt von Big Data als Thema benötigt, sondern sind gegebenenfalls eine Folge des neuen Felds oder waren in ähnlicher Ausprägung bereits bei Unternehmen vorhanden. Daher haben wir auf genauere Klassifizierung dieser Rollen in diesem Artikel verzichtet – aber wir möchten nicht vorenthalten, dass es wesentlich mehr Beteiligte im Big Data Umfeld gibt.

Zusammenfassung

Zusammengefasst können wir sagen, dass der Big Data Hype noch nicht vorbei ist. Wir befinden uns inzwischen in der Phase der Realität: Unternehmen und Menschen haben erkannt, dass die Verarbeitung von großen Datenmengen nicht einfach verschwinden, sondern in Zukunft immer weitere Teile unseres Lebens einnehmen wird. Und je näher sich Organisationen in die Richtung einer Data Driven Company bewegen, umso wichtiger ist es, diese Technologien zu verstehen und deren Effekte abschätzen zu können.

Daher hoffen wir, dass wir mit unserer Big Data Definition, den dazugehörigen Merkmalen, Technologien und Big Data Analytics einen guten Überblick geben konnten, was alles an der den großen Datenmengen hängt. So geht es nicht nur um die Daten selbst, sondern um die größere Idee, dass man mittels Datenanalyse viele neue Ansätze finden kann, ein Unternehmen voran zu bringen. Dazu gehört neben Technologie auch viel Expertise und vor allem ein gewisser Mut, sich auf diesen Weg zu begeben.