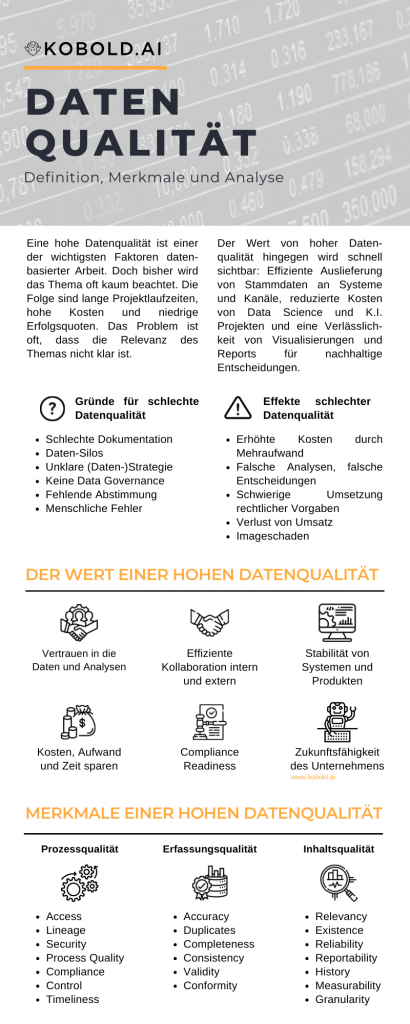

Datenqualität wird in Unternehmen immer wichtiger. Einerseits werden viele Probleme durch schlechte Datenqualität verursacht, andererseits bietet eine hohe Qualität der Daten eine Vielzahl an Vorteilen für Unternehmen, die mit den Daten arbeiten möchten. In diesem Artikel gehen wir auf die Definition von Datenqualität ein, bevor wir Merkmale, Probleme und auch Vorteile einer hohen Qualität von Daten aufzeigen.

Definition: Was bedeutet Datenqualität?

Datenqualität ist die Korrektheit der Erfassung und Inhalte von Daten. Eine niedrige Datenqualität meint dabei meist, dass Daten fehlen, sie inkorrekt oder inkonsistent sind.

Der Zeitpunkt an dem das Thema Datenqualität aufkommt ist meist der, wenn Daten eingesetzt werden sollen und eine der Beteiligten merkt, dass etwas nicht stimmt. Dieses “nicht stimmen” ist mit Absicht so vage formuliert, denn die Ausprägung von einer niedrigen Datenqualität kann in vielen Aspekten festgestellt werden: Von fehlenden Daten über Duplikate (Dubletten) bis hin zu falsch erfassten Daten gibt es viele Ausprägungen von schlechter Datenqualität.

Spricht man daher von Datenqualität in einem Unternehmen, wird meist der konkrete Inhalt und dessen Richtigkeit von spezifischen Daten gemeint.

Infografik Datenqualität in Unternehmen

Wie kann Datenqualität in das Thema Data Governance und Data Management eingeordnet werden?

Datenqualität ist ein Thema im Bereich Data Management, was die operative Anwendung von Data Governance darstellt. Der Unterschied ist, dass durch Data Governance die Ziele, Prozesse, Organisation und Richtlinien für Datenverwaltung festgelegt werden, während Data Management diese Rahmenbedingungen umsetzt.

So kann der generische Begriff “Datenqualität” eigentlich unterteilt werden in die Vision (z.B. “Wir möchten jederzeit verwendbare, relevante Daten besitzen”) und die eigentliche Umsetzung durch Data Stewards mittels Systeme und Prozesse.

Die finale Unterscheidung beruht darauf, dass Datenqualität oft nur auf die Struktur und den Inhalt der Daten bezogen wird, nicht aber auf die Qualität des Datenprozesses. Dieses Thema ist jedoch die Basis für alle Aktivitäten im Data Management, folglich muss es in der Qualität der Daten beachtet werden.

Probleme die durch schlechte Datenqualität entstehen

So ziemlich jedes Unternehmen hat negative Erfahrungen mit schlechter Datenqualität gemacht. Dies ist nicht verwunderlich: Daten setzen an so ziemlich jedem Unternehmensprozess an und eine schlechte Qualität der Daten führt zu einem schlechten Ergebnis innerhalb des Prozesses. Hier eine Liste an Problemen, die durch schlechte Datenqualität entstehen können.

Erhöhte Kosten durch den Mehraufwand bei schlechter Datenqualität

Egal ob bei Kunden oder Lieferanten – schlechte Stammdatenqualität kann dazu führen, dass Angebote falsch geschrieben werden, Service-Mitarbeiter vor der falschen Adresse stehen oder die Lieferungen an die falschen Orte gehen. Daher ist es zunehmend wichtig für den Bereich Operations, dass alle Unternehmensdaten so korrekt wie möglich sind.

Falsche Analysen durch eine niedrige Qualität der Daten

Mit der Zunahme an datenbasierten Arbeiten, Datenanalysen und Data Science Anwendungsfällen nimmt auch die Wichtigkeit von Datenqualität zu. Falsche Analysen oder falsche Machine Learning Modellierung führt schnell dazu, dass falsche Entscheidungen getroffen werden. Und dies kostet schnell Geld: Egal ob niedrigere Effekte, falsche strategische Entscheidungen oder falsche Überwachung der Geschäftsprozesse – die Korrektheit beruht auf der Datenqualität.

Probleme bei der Umsetzung rechtlicher Vorgaben (Compliance)

Während es in vielen Punkten um Effizienz, verlorenen Umsatz oder ähnliches geht, wird es bei rechtlichen Gesetzeslagen schnell geschäftsgefährdend. Speziell in Zeiten von DSGVO und dem Recht auf Vergessen-Werden wird fehlende Data Governance, falsche Verknüpfung oder fehlende Dokumentation schnell zu einem weitreichenden Problem.

Verlust von Umsatz durch mangelnde Stammdatenqualität

Ein weiteres Problem von mangelnder Datenqualität ist eine direkte Auswirkung auf den (potentiellen) Umsatz. Speziell im Bereich Stammdaten ist hierbei Sorgfältigkeit angebracht. Wenn kein sauberes Lead Management betrieben wird, Kundendaten nicht gepflegt werden oder Transaktionsdaten qualitativ nicht zur Analyse von Produktempfehlungen oder Segmentierung genügen, geht schnell Umsatz verloren.

Imageschaden durch schlechte Daten

Ein letztes, aber dennoch sehr wichtiges Thema das vielen oft nicht direkt bewusst ist: Auch das Image eines Unternehmens kann unter einer schlechten Qualität der Daten sehr leiden. Zum Beispiel wenn die Qualität im Bereich Stammdaten niedrig ist, werden gegebenenfalls falsche Produktinformationen über die Kanäle an den Kunden kommuniziert. Dies führt zu Verwirrung oder Frustration, wenn man andere Produkte bekommt als man erwartet.

Ein anderes Beispiel befindet sich im Bereich der User Experience. Wenn Kunden eine Lieferung erwarten und diese aber auf falschen oder nicht aktuellen Daten beruht, wird der Kunde ein sehr schlechtes Erlebnis haben.

Wie schlechte Datenqualität in einem Unternehmen entsteht

Schlechte Dokumentation von Daten

Bei mangelnder Data Governance ist nicht klar, wann, wie und wo man Daten dokumentieren kann oder soll. Folglich ist unklar welche Daten vorhanden sind, welche Attribute diese besitzen oder wie sie eingesetzt werden. Dies führt direkt zu schlechter Datenqualität einerseits, aber zu einer sehr schlechten Qualität des Gesamtprozesses andererseits. Daher ist schlechte Dokumentation von Zieldaten als auch des vorhandenen Inhalts meist direkt im Zentrum einer mangelnden Datenqualität.

Daten-Silos

Durch den historisch bedingten Aufbau von Datensilos bestand nie die Notwendigkeit, die Daten anderweitig einzusetzen. Weder über Systeme hinweg zu verbinden (Data Unification) noch zentral zur Analyse zu sammeln (z.B. via Data Lake). Durch diesen mangelnden Einsatz und die Existenz von Datensilos war Datenqualität nie im Fokus, da Daten oft innerhalb eines Systems besser gepflegt sind als über Systeme und Einsatzzwecke hinweg. Nach und nach werden diese Legacy-Systeme abgelöst und die Verknüpfung von Silos wird noch mehr an Relevanz gewinnen.

Unklare Strategie

Wenn es keine klare Datenstrategie gibt, kann im Unternehmen auch keine Vision vermittelt werden. Folglich sind die grundlegenden Arbeiten wie der Aufbau einer einheitlichen Dateninfrastruktur, Expertise im Data Engineering oder eben Data Governance selten von Priorität.

Keine Data Governance

Ganz offensichtlich ist das organisatorische und strategische Fehlen einer Data Governance Initiative grundlegend für die fortgeführte niedrige Datenqualität. Data Governance ist das direkte Entgegenwirken, weshalb die Unternehmen die es nicht etabliert haben, auch stärker mit schlechter Qualität von Daten kämpfen.

Fehlende Abstimmung zwischen Technik und Domäne

Oft fehlt einfach klare Abstimmung zwischen den verschiedenen Fachbereichen um klar zu definieren, welche Daten in welcher Form am effektivsten sind.

Menschliche Fehler

Je nach Studie sind Menschen für bis zu 60% der Fehler in den Daten verantwortlich. Daher muss sich jedes Unternehmen zum Ziel setzen, mittels Prozessen, technologischen Vorsichtsmaßnahmen und klaren Data Governance Prinzipien seine Angestellten zu trainieren und zu unterstützen, seinen Beitrag zu einer hohen Datenqualität zu leisten.

Wie eine hohe Datenqualität definiert ist und warum sie so wichtig ist

Wie genau eine hohe “Data Quality” definiert ist, ist individuell für jedes Unternehmen zu bestimmen. Der generelle Konsens ist, dass die Datenqualität hoch ist, wenn die Daten verfügbar und einsetzbar für den intendierten Zweck sind. Aber diese generische Definition gilt es natürlich mittels einem zugeschnittenen Data Governance Programm genau auszudefinieren und mittels KPIs zu untermauern.

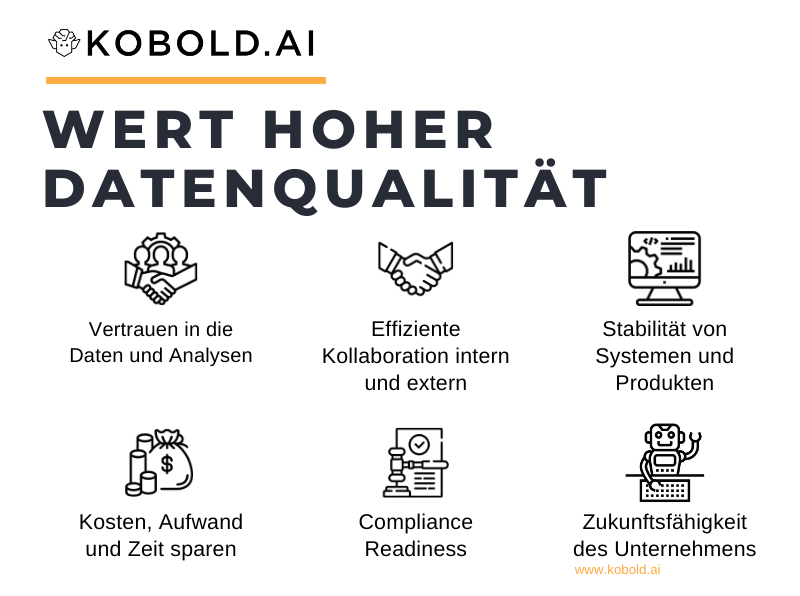

Während die genaue Definition und deren Implementierung im Unternehmen individuell ist, gibt es jedoch einige generelle Kategorien in denen eine hohe Datenqualität einen positiven Effekt erzielt. Diese Kategorien finden sich in fast jedem Unternehmen wieder und gelten daher als Richtlinie, weshalb es sich lohnt, in eine hohe Qualität von Daten zu investieren.

Vertrauen in die Daten durch bessere Entscheidungen, bessere Entscheidungen durch Vertrauen in die Daten

Es ist ein Kreislauf. Wenn man gut analysierten Daten vertraut (“Data Confidence”) und Entscheidungen darauf basiert, hat man eine bessere Ausgangslage. Dies funktioniert allerdings nur, wenn die Daten vertrauensvoll sind: Liegt schlechte Datenqualität zugrunde und man trifft darauf basierend eine falsche Entscheidung, wird dies natürlich das Vertrauen in die Daten zerstören.

So ist es nicht überraschend, dass 84% der Geschäftsführer Bedenken bezüglich der Datenqualität in ihrem Unternehmen haben – und dementsprechend den Daten nur bedingt vertrauen. Und dementsprechend ihre Entscheidungen doch wieder Bauchgefühl treffen.

Dieser Kreislauf kann nur durchbrochen werden, wenn die Qualität der hoch ist. Denn dann kann man die Daten als das Werkzeug einsetzen, für das sie gedacht sind.

Konsistenz und Kohärenz der Daten sind die Grundlage für ein gemeinsames Arbeiten

Wenn Daten bei jeder Auswertung anders interpretiert werden, wenn unterschiedliche Reports unterschiedliche Zahlen ausweisen, wenn verschiedene Zweigstellen des Unternehmens unterschiedliche Lagerbestände angezeigt bekommen – all dies sind Faktoren dafür, dass eine schlechte Datenbasis die Grundlage der Zusammenarbeit zerstört.

Folglich kann man effizient und stringent zusammen arbeiten, wenn man die gleiche Basis in den Daten hat. Und diese erreicht man durch Data Governance einerseits, aber auch rein indem man die Datenqualität an sich anhebt, um potentielle Fehler zu minimieren.

Datenqualitätsanalyse von Kundendaten

Analyse von Kundendaten im Bezug auf Datenqualität wie Vollständigkeit, Validität, Korrektheit und anderes.

Stabilität von Systemen und Produkten durch hohe Datenqualität

IT-Abteilungen oder spezieller Data Engineers sind oft damit beschäftigt, Data Pipelines zu reparieren nachdem eine Änderung vorgenommen wurde oder sich das Ursprungsformat der Daten geändert hat.

Zusätzlich gibt es oft genug weitere Probleme durch Daten, die in einer Pipeline auftauchen, aber nicht erwartet sind. Entweder weil diese Art von Daten nicht im Startsystem nicht dokumentiert waren oder weil sie nicht dem Standardformat entsprechen – beides Aspekte von einer niedrigen Datenqualität.

Im schlimmsten Fall führen solche Fehler in Data Pipelines dazu, dass nachfolgende Systeme nicht mehr operieren können. Ganz offensichtlich führt dies – je nach System – zu starken Einbußen im täglichen Geschäft, was durch eine verbesserte Datenqualität verhindert werden kann.

Data Science Expertise fokussiert einsetzen statt Daten zu säubern

Im Bereich der Datenanalyse sind die Experten von Data Science und Machine Learning mitunter 70% der Zeit damit beschäftigt, die vorliegenden Daten zu suchen, säubern und vorzubereiten. Dies ist eine aufwendige, frustrierende Aufgabe, die durch eine hohe Datenqualität komplett abgelöst werden kann. Folglich kann die Expertise viel zielgerichteter eingesetzt werden statt dass sich Data Scientists damit beschäftigen müssen. Zusätzlich erlaubt eine hohe Data Quality auch immer eine höhere Qualität der Gesamtergebnisse – somit also ein doppelter Effekt.

Kosten, Aufwand und Zeit sparen durch hohe Datenqualität

Wie bereits aus den verschiedenen Aspekten ersichtlich, kostet schlechte Datenqualität ein Unternehmen Geld, Aufwand, Zeit und Ansehen. Daher kann man durch eine kontinuierlich hohe Datenqualität in all diesen Aspekten gewinnen. Sowohl direkte Kosten wie Downtime, als auch indirekte Kosten wie der Aufwand zur Behebung von Problemen oder Image-Einbussen müssen hier beachtet werden.

Insgesamt zahlt eine hohe Datenqualität darauf ein, dass man sich weniger mit Meta-Themen beschäftigen muss. Es gibt weniger Verzögerungen in Umsetzungen weil Daten direkt, einfach und in hoher Qualität bereit stehen und Projektbudgets werden insgesamt weniger belastet da die Datenextraktionen ohne Probleme durchgeführt werden.

Um den Effekt minimal zu quantifizieren: Laut einer Studie von IBM im Jahr 2016 geht jedes Jahr in etwa 3.1 Trillionen US Dollar Verlust durch schlechte Datenqualität einher.

Compliance readiness: Bereit für Datenschutz und DSGVO

Weiter oben als eines der größten Probleme definiert, kann man das Problem bei hoher Datenqualität entsprechend als Vorteil definiert werden. Wenn man eine hohe Datenqualität etabliert hat, erlaubt dies eine sehr einfache Einhaltung von rechtlichen Vorgaben wie beispielsweise dem “Recht auf Vergessenwerden” oder die Auslieferung aller gespeicherten Daten.

Da sich die Kontrolle über die eigenen Daten in Zukunft immer weiter in Richtung Kunden verlagern wird, gilt es als fundamental auf die entsprechenden rechtlichen Vorgaben vorbereitet zu sein. Dazu zählt eine genaue Nachverfolgbarkeit von vorhandenen Daten, Dokumentierung der Inhalte und einfache Querverbindung aller Datenquellen, in denen sich Kundendaten befinden. Und dies sind alles Themen für eine hohe Datenqualität.

Der Kunde als Nutznießer hoher Datenqualität

Während es viele interne Prozesse gibt, die sehr stark von hoher Datenqualität profitieren, ist es am Ende der Kunde, der immer mitprofitiert. Ob nun effizientere oder personalisierte Kanäle, ob schnellere Verarbeitung, bessere Produkte oder Services: Alles zahlt darauf ein, dass die Kunden einen Vorteil haben.

Daher darf Datenqualität nicht isoliert für interne Aufgaben betrachtet werden, sondern muss bis ans Ende der Prozesskette gedacht werden. Viel der Information, ob nun Stammdaten oder Transaktionsdaten, haben schlussendlich einen Einfluss auf die Kanäle und somit direkt auf den Kunden.

Eine hohe Datenqualität führt zu höherem Umsatz

Einer Studie von Thomas Redman zufolge verpassen Unternehmen jedes Jahr ca. 15% bis 25% an Umsatz pro Jahr durch mangelnde Datenqualität. Die Logik ist relativ einfach: Wenn man zuverlässige, validierte Daten von hoher Qualität zur Verfügung hat, kann man alle nachfolgenden Prozesse sehr verlässlich steuern.

Dieser direkte Einfluss schlägt sich in höherem Umsatz nieder. Prozesse können effizienter durchgeführt, Kunden besser betreut und Bestellungen schneller erfüllt werden. Ganz zu schweigen von personalisiertem Marketing und dynamischer Preispolitik. Alles mündet in Verbesserung von Prozesse um Kosten zu minimieren und bessere Betreuung für höheren Umsatz.

Die Zukunft wird durch die Daten definiert – und die Qualität hat einen großen Einfluss

Wir sind der festen Überzeugung, dass die Zukunft den Data Driven Companies gehört. Jene Unternehmen, die aktiv Daten aufnehmen, speichern und verwerten werden einen Wettbewerbsvorteil haben gegenüber Unternehmen, die diese nicht tun.

Da allerdings nur das Vorhandensein von Daten keinen Vorteil bringt, sondern die verarbeitungsbereite Bereitstellung und entsprechende Verwertung, ist Datenqualität neben Infrastruktur, Organisation und Expertise eine der Hauptvoraussetzungen auf dem Weg zur Data Driven Company. Nur dann kann ein Unternehmen bereit in die Zukunft gehen, seine Prozesse entsprechend skalieren und den Anforderungen von Big Data, Data Lakes, Data Science und Machine Learning trotzen.

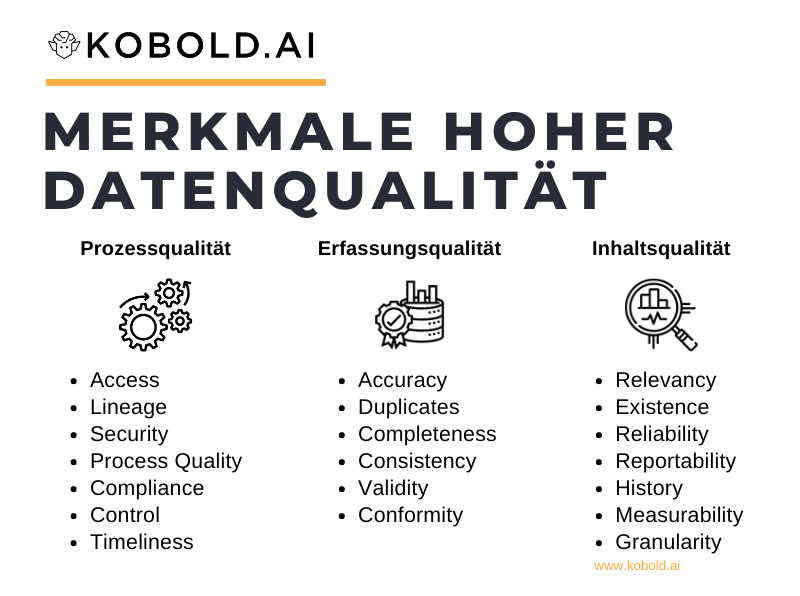

Welche Merkmale bzw. Dimensionen von Datenqualität gibt es?

Es gibt eine ganze Bandbreite an Merkmalen, die einen einfluss auf die Datenqualität ausüben. Dabei unterscheiden wir in drei Kategorien: Die Qualität der Datenerfassung, die Qualität des Inhalts und somit der Wert der Daten selbst, sowie die Qualität des Prozesses zur Datenerfassung und -nutzung. Gemäß der Definition von Data Governance würde sich daher auch die Prozessqualität rein auf den Bereich Data Governance beziehen, die Datenerfassungsqualität auf klassische Attribute assoziiert mit der Struktur und Ausprägungsform von Daten und der Datenwert auf Attribute mit dem semantischen Inhalt der Daten.

Wenn man üblicherweise von “Datenqualität” spricht, meint man vor allem die Qualität der Datenerfassung und des Inhalts, weniger den Prozess der sich um die Erfassung, Kontrolle und Verwaltung von Daten dreht.

Merkmale einer hohen Datenprozessqualität

Mit Datenprozess sind Attribute gemeint, die die Sicherheit, den Zugang, die Historie und Kontrolle über Daten beschreiben.

Data Access (Zugriff auf Daten)

Wenn kein Zugriff auf die Daten möglich ist, ist selbstverständlich die Existenz hinfällig. Data Access ist daher relativ zentral, vor allem ein Ziel zu setzen, dass man schnell, sicher und einfach Zugriff bekommt.

Data Lineage (Stammbaum / Nachverfolgbarkeit von Daten)

Als Data Lineage wird die Verfolgbarkeit der Datenherkunft und Datennutzung genannt. Zum Beispiel, dass für jede Datenquelle klar ist, welchen Ursprung (z.B. System) sie hat und in welchen Analysen und Prozessen sie eingesetzt wird.

Data Security (Sicherheit von Daten)

Ein sehr großes Thema im Prozess der Datenverarbeitung ist die Sicherheit. Sowohl aus der Sicht von Infrastruktur, Zugang als auch Backups.

Data Process Quality (Datenprozessqualität)

Data Process Quality meint ob klar definiert ist, wie man auf Daten zugreift, neue Quellen anbinden kann, weiterverarbeitet und ähnliche Prozesse durchführen kann.

Data Compliance (Ordnungsmäßigkeit)

Compliance, also die Einhaltung von gesetzlichen und datenschutzrechtlichen Richtlinien, ist ein sehr wichtiger Teil des Prozesses in der Datenverwaltung.

Data Control (Kontrolle)

Als Data Control wird die generelle Handhabung von Daten und des Prozesses betitelt. Höher skaliert bezieht sich die Datenkontrolle auf den gesamten Bereich von Data Governance und Data Management.

Data Timeliness (Zeitlosigkeit / Aktualität von Daten)

Daten, die aktuell sind, können korrekt eingesetzt werden. Hierbei zählt der Updateprozess, vor allem wenn die technische Grundlage ein Batch Processing ist, eine große Rolle.

Datenqualitätsanalyse für Produktdaten

Unsere vollautomatische Produktdatenqualitätsanalyse auf mehr als 35 Metriken erlaubt nachhaltige Identifikation und Verbesserung der Datenqualität.

Dimensionen der Datenerfassungsqualität

Die Qualität der Datenerfassung bezieht sich auf die am häufigsten betrachteten Attribute in der Datenqualität bzgl. Vermeidung von schlechtem Dateninhalt bereits auf der technologischen Ebene.

Data Accuracy (Genauigkeit der Daten)

Beantwortet die Frage, ob der Inhalt der Daten auch dem Attribut entspricht. Zum Beispiel, dass “Geburtsdatum” auch einen korrekt formatiertes Datenobjekt enthält, das das Geburtsdatum beschreibt.

Data Duplicates / Data Uniqueness (Dubletten)

Das Gegenteil von “Uniqueness”, also der Einzigartigkeit eines Dateneintrags, ist das Data Duplicate. Ob innerhalb eines Datensystems oder über Datensysteme hinweg gilt es zu vermeiden, dass es Dubletten gibt, bei denen unklar ist, welche die Grundwahrheit bilden (sog. Ground Truth).

Data Completeness (Vollständigkeit von Daten)

Die Vollständigkeit meint vor allem zu Unrecht fehlende Werte. So gibt es beispielsweise Attribute die zu Recht fehlen (z.B. im Attribut “Doktortitel” erwarten wir keine Vollständigkeit), aber auch welche die fälschlicherweise fehlen (z.B. Kunden-Nummer).

Data Integrity (Integrität)

Die einheitliche Weiterführung von Daten über ihren Lebenszyklus, so dass weder Inhalt noch Format geändert werden. Als Beispiel gilt, dass nicht plötzlich ein Attribut namens “Inhalt_Liter” plötzlich Milliliter ausweist.

Data Consistency (Konsistenz von Daten)

Data Consistency bezeichnet die Konsistenz eines Datums über ggf. Verschiedene Datenbanken oder Datenbanksysteme hinweg. Es muss vermieden werden, dass zum Beispiel eine Transaktion in einer Datenbank geändert ist, in anderen aber noch den Originalwert aufweist.

Data Validity (Validität von Daten)

Die Datenvalidität ist ein technisches Attribut, welches sich auf die Syntax und Datentypen eines Datums bezieht. So muss beispielsweise vermieden werden, dass in einem String-Attribut rein numerische Zahlen gespeichert werden.

Data Conformity (Konformität von Daten)

Datenkonformität bezeichnet das Folgen von zu erwarteten Datenformaten. Als einfaches Beispiel gilt eine Datumsangabe, die zum Beispiel DD.YYYY.MM formatiert ist, würde gegen Data Conformity verstoßen.

Attribute der Dateninhaltsqualität

Data Relevance (Relevanz der Daten)

Die Data Relevance bezieht sich auf die inhaltliche Relevanz der aufgenommenen Daten. Dieses Attribut wird immer diskutiert, wenn die Frage gestellt wird, welche Daten aufgenommen werden.

Data Existence (Existenz von Daten)

Ganz simpel – existieren die Daten, die man intendiert zu nutzen, überhaupt in der Auflösung und Wahrheit die wir voraussetzen.

Data Reliability (Verlässlichkeit)

Daten sind verlässlich, wenn sie gemäß der Nutzung genügend komplett, korrekt und genau sind. Folglich ist es eine Summe aus anderen Aspekten, die definiert, ob die Daten überhaupt eingesetzt werden können.

Data Reportability (Berichtbarkeit von Daten)

Können die Daten genutzt werden, um mittels Reports oder Visualisierungen vermittelt und somit in die Organisation zurück gespielt zu werden.

Data History (Historie der Daten)

Wie weit können wir die Historie der Daten zurückverfolgen und Veränderungen analysieren. Vor allem in Themen des Internet of things wird es immer relevanter, die Geschichte von Edge-Devices zu kennen, um adäquat reagieren zu können.

Data Measurability (Messbarkeit von Daten)

Die Frage der Messbarkeit ist, ob wir den Dateninhalt in Relation zu etwas setzen können. Zum Beispiel sind Daten, die ohne Indikation über ihre möglichen Ausprägungen gehalten werden, schwierig zu handhaben, da nicht klar ist, in welchem Quantile sie in der Range liegen.

Data Granularity (Auflösung der Daten / Messgenauigkeit)

Die Granularity von Daten bezeichnet die Auflösung. Beispielsweise können Zeitangaben von Millisekunden bis Monate aufgelöst sein und je nach Anwendungsfall unterschiedliche Granularity benötigen.

Ansatzpunkte zur Verbesserung der Datenqualität

Wir haben ausführlich und transparent dargestellt, weshalb eine gute Datenqualität zentral für jedes Unternehmen sein muss. Doch wie beginnt man, das Thema umfassend zu bearbeiten? Hier schlagen wir eine Reihe an Ansätzen zur Verbesserung der Datenqualität vor, die noch besser wirken, so sie kombiniert werden.

Training und Workshops zur Etablierung des Mindsets

Einer der wichtigsten Ansatzpunkte zur Verbesserung der Qualität der Daten ist die Etablierung eines gemeinsamen, datenzentrierten Mentalität. Hierzu gilt es, die Probleme und Vorteile im Zusammenhang mit Datenqualität darzustellen und zu vermitteln. Das Ziel ist es, alle Angestellten in den Prozess einzubinden um somit eine breite Verantwortung für die gemeinsame Verbesserung der Datenqualität sicher zu stellen.

Data Governance ist zentral für langfristige Datenpflege

Im Herz jeder Bewegung in Richtung guter Datenqualität steht ein Data Governance Programm. Data Governance ist der strategische, prozessuale und verwaltende Aspekt, während Data Management der ausführende Arm ist. Gemeinsam gilt es, das Thema Data Quality als zentral zu etablieren, Prinzipien zu definieren, eine Organisation zu schaffen und entsprechende Befähigung zu etablieren. Dazu gehört auch die Bereitstellung von notwendiger Software, Kapazität und klarer KPIs, in dessen Richtung gearbeitet wird.

Der Data Steward als Wächter der Datenqualität

Eine der wichtigsten Rollen im Thema Data Quality ist der Data Steward. Seine Verantwortung ist die Überwachung, Detektion, Kontrolle und Korrektur von schlechter Datenqualität. Zudem gilt es, Quellen schlechter Datenqualität zu beheben.

Andere am Prozess beteiligte Rollen können der Data Quality Manager, Data Quality Analyst, Data Engineers, Data Governance Managers oder Data Tool Managers sein. Ob nun eine dieser Rollen oder der Data Steward selbst: Es muss dedizierter Platz für das Thema in der Organisation geschaffen werden, um die entsprechende Wichtigkeit zu vermitteln.

Im Optimalfall ist es auch nicht nur ein Data Steward, sondern viele Data Stewards die im Unternehmen verteilt sind. Möglichst nah an Quelle und Einsatz der Daten gilt es, Domänenexpertise mit fachlichem Wissen zu kombinieren, um die Data Quality möglichst hoch zu halten.

Data Downtime als Hauptmetrik für die Qualität der Daten

Eine der häufigsten Fragen im Bezug auf Data Governance und Data Quality Management ist die Frage der Rentabilität. Davon abgesehen, dass sie kaum zu messen ist, da Datenqualität Auswirkung auf so viele Querfunktionen und Effizienzen hat, gibt es dennoch den Versuch eine KPI zur quantifizieren zu etablieren.

Als sogenannte “Downtime” wird alles zusammengefasst, was als messbarer Einfluss von negativer Datenqualität gesehen werden kann. Das bedeutet, dass die Zeit in denen Daten als fehlerhaft, nicht verfügbar, fehlend oder anderweitig beschränkt verfügbar sind, erfasst wird. Als Berechnung gilt:

> Data downtime = Number of data incidents x (Time-to-Detection + Time-to-Resolution)

Die Idee ist, dass herkömmliche Merkmale wie Completeness schwer zu messen sind. Data Downtime hingegen ist eine aggregierte, einfach zu quantifizierende Metrik, die schnell zeigt, wie es um Data Quality im Unternehmen steht.

Automated Data Quality Assessment – Automatisierung von Datenqualität

Ein weiterer Baustein in der Verbesserung der Datenqualität ist die automatisierte Detektion von Verstößen gegen eingeführte Richtlinien. Dies kann einerseits einfach mittels Tools und Dashboards geschehen, andererseits aber auch vollautomatisiert mittels Machine Learning.

Das Ziel hierbei ist entweder die Unterstützung von Data Stewards im Data Management oder direkte Klassifizierung von Einträgen schlechter Datenqualität, um sie abzuweisen. Mit zunehmender Konsolidierung von Datenquellen in einem Data Lake wird auch die Governance zunehmen, weshalb solche Vorgehen immer mehr Standard werden.

Unsere Empfehlung: Datenqualitäts-Analysen von Kobold AI. Einfach Analyse auswählen, Daten hochladen und Ergebnisse direkt bekommen. Ohne Aufwand Einblicke in Probleme bekommen, um schnell die Qualität zu erhöhen.

Eine hohe Datenqualität wird in Zukunft immer wichtiger – jetzt ist Zeit zu handeln

Wir haben umfassend dargestellt, weshalb Datenqualität zentral für jedes Unternehmen sein muss. Tatsächlich wird mit der Zunahme an Analysen, Künstlicher Intelligenz und Verknüpfung verschiedener Systeme auch die Notwendigkeit einer hohen Qualität von Daten zunehmen. Folglich wird Data Quality als Thema auch immer mehr jene Unternehmen von denen differenzieren, die sich nicht entwickeln.

Zusammengefasst ist das Thema Datenqualität im generellen sehr weitreichend und für jedes Unternehmen muss die richtige Skalierung, die richtigen Metriken und die richtigen Ansatzpunkte gefunden werden, damit die Qualität der Daten im Fokus stehen kann, ohne alles andere zu erschlagen.